【Z・特別講義20】

[ マイクAMPの初段増幅回路の設計法 ]

第二十回寄稿

早いもので、寄稿の執筆を始めて1年5ヶ月が経ち、回を重ねて20回目を迎えました。

これもひとえに、読者の方々の応援の賜物だと感じております。 記述不備を沢山ご指摘頂き、感謝の念に堪えません。

何処まで続くか?書いている本人にも分からない状態ですが、デジタル信号の薀蓄を語る処までは、何とか到達したいと考えております。

今回も恒例によりまして、読者様のご質問・ご意見に答える形で進めて参りましょう。

******************************************

ご質問1

毎回楽しく拝見しています。 たしかに、現在のハイレゾはCDに負けています。デジタルは進歩しているようでほとんど進歩がないんでしょうか。

******************************************

既に解説しました通り、原理的な分野に於いてデジタル信号処理の手法開発では、大きな進展は無い時代にさしかかっております。 もう少し詳しく見ると、信号処理周波数的には半導体の微細化によって、ハイサンプリング化が可能となりDSD信号でも256fs化(11.2896MHz)が可能になりました。

信号の伝送帯域的には、人間の聴覚性能に鑑みて、これで十分であると考えます。

しかしながら、信号の振幅方向のダイナミックレンジは、まだまだ不足しているのが現状です。

毎度おなじみの、この課題を解決する為には、高速処理化と大振幅化が同時に必要ですが、半導体製造では物理的に矛盾する関係にあり、この解決にはシリコン系素子を卒業する必要がありましょう。

俗に言われるガリウムヒ素系の半導体は、高速かつ高電圧化が可能で、市場ニーズがあればAudio専用の増幅・信号処理半導体が開発される可能性があります。

既に述べました通り、Power系半導体にその先ぶれが見て取れます。

又繰り返しになりますが、DSD信号はその出口まで同じ信号形式でPower段まで通すべきで、途中で他の信号形式に変換すると、必ずその段階で劣化を伴います。

その意味で非同期式レートコンバーターは、決して万能薬では無い事を正しくご理解下さい。

但しデジタル伝送時の、時間軸の揺れである、ジッター問題を大きく改善した事は事実です。

ハイレゾ信号処理もノウハウが徐々に積み上がり、本格的な音楽再生に適合可能な商品も登場して来ており、開発者の練度向上を暖かく見守って下さい。(ここでもアナログ段の処理が性能を大きく左右します)

今後の発展方向は、デジタル系・アナログ系を問わず半導体に加える電圧を高くして、且つ高速処理する方向に、発展して行くものと推定されます。

******************************************

ご質問2

いつも楽しく読ませてもらっています。 ひとつ、これができたらいいな、と思うことがありました。

「ダイナミックレンジ圧縮」されたCDでも、イコライザーかなにかで、上手によりよい音質で再生するテクニックはあるのでしょうか?

もし可能でしたら、いつかご講義いただきたく思います。

******************************************

ダイナミックレンジ(以下Dレンジ)圧縮技術の応用は、アナログ時代ではノイズの抑圧に、沢山使われて来ました。その応用代表例が、Dolby方式のアナログ信号の磁気記録再生方式でした。

しかし、デジタル信号処理時代は比較的容易にDレンジが改善出来ますので、信号の振幅方向を民生機器段階で操作する事が無くなっております。

レコーディング・スタジオでは、今でもDレンジ圧縮は頻繁に使用されます。 その故は音楽信号を集音する段階で、信号処理側のDレンジが不足するからです。

アナログ小信号をA/Dコンバ-タ-迄導く段階で、Dレンジが不足するからです。 つまり、CDに記録する時の大振幅信号は、圧縮しっぱなし・・の状態で市場に出回っております。

圧縮方式(リミッター)は各レーベルによって、考え方が違います。

この時CD作成時の、Dレンジ圧縮条件は業界としての標準ルールが事実上存在せず、どのレベルから上を圧縮するか?等は各社各様です。 ピークエネルギーのリミッターが主流のようです。

記録と再生で圧縮・伸長を行う手法は、一般にはコンパンダーと呼ばれます。(その昔アナログの磁気記録時代にdbx方式として、業務分野では沢山使用された実績があります。)

CDはイコライザーで記録時に高域を上げて、再生時にCDに書かれた特別のトラック(TOC)を読み込んで高域を下げる事をするのが大半でした。 しかしこの手法によるS/N改善手法は、音質が悪い・・との市場評価があり、現在ではこのS/N改善手法は、下火になっていると思います。

ともかく、ダイナミックレンジを改善する目的で、時間軸で操作する事は、音質劣化に繋がるので時代のトレンドから外れた存在となり、それよりも処理Bit数を上げる方向にある様です。

同時に、サンプリング周波数を上げる方向ですが、伝送帯域が広がった分、S/N劣化の要因となります。

*****************************************

質問3

いつも勉強させていただいております。

私は、理系ではなく、ましてや文系でもない美術系出身者です。絵を描く以外脳がないです・・・。

今回の特別講義8「スピーカーケーブルについて」は、日々悩んでいた内容でしたので、興味深く拝読いたしました。

自分は、リスニングだけでなく、音楽制作でオーディオ装置を使っており、なるべくロスをなくしフラットな特性での試聴を目標としております。

今回取り上げられたスピーカーケーブル(ラインケーブルも)につきまして、撚り線と単線の差異については特に書かれておりませんでした。現在自分は、OFC 0.8mmの単線をツイストしたケーブルを使用しております。

単線の優位性というのは、理論的にあるのでしょうか?

端子間での圧着は分子構造を合体させることで、半田付けより有利だとお書きになっておりました。

ご意見をお聞かせいただければ幸いです。

******************************************

これも既に解説文の中で説明しましたが、原理的には低い周波数では単線が有利に働きますが、高い周波数帯域には撚り線が有利に作用します。

しかし、家庭内配線では同時にケーブルの柔らかさが求められますので、撚り線が主体の市場を形成しております。 その意味ではWoofer駆動は太い単線、例えばOFCのφ2単線ケーブルが向くものと考えます。(電線による音質差は存在)

中高域をマルチチャンネルで駆動すれば、逆に撚り線が有利に働く筈ですが、コスト対効果の面ではケーブルの銘柄差の方が、影響度は大きいかも知れません。

既に述べました通り、業務分野でのケーブルの音質は、ほとんど問題視されません。

それはアナログ信号の品質が、記録再生系とは異なり、生信号は圧倒的に優れているからです。 以下小信号回路の構成でも記述しますが、それよりも伝送ライン上のインピーダンス・マッチング処理問題が、圧倒的に重要なアイテムとなります。(業務分野での伝送線路長は、長い事が一般的)

ケーブルと各信号端子との間は、解説しました如く圧着工法に勝る品質UP対策はありません。

銅分子間が完全に融合させる結合方法を以て、対策の止めとします。

自作されるのであれば、圧着結合を強く推奨します。 特に近年は、鉛系の有害さが露呈し、半田性能を満足させる優れた素材が、一般市場で入手困難です。(銀入り半田が市販されております)

*****************************************

ご質問4

とても興味深いご説明です。私はある放送局で音声ディレクターを長年やってきました。

正直ケーブルの違いは判断できません。 ではなぜケーブルの良し悪しについてオーディオマニアは問題にするのでしょう。 少しでも自分のシステムを最良の状態にしたいからでしょう。

音楽は空気の振動であることを考えれば、おそらくケーブルの検討よりも、先に検討すべき事柄があるように思います。ケーブルの検討は検討順位ではかなり下位になるのではないでしょうか。

重要な生放送で音声技術者は、先ず使用するプラグを磨くことから仕事が始まります。 あらゆる意味で万全を期するためです。

それを考えるとケーブルの端末の処理は大変に大事であるというご指摘は、傾聴に値するご指摘であると思います。 どんなに高価なケーブルを使用しても、その使い方が適切でなければ、ということでしょう。次回のリポートを楽しみにしております。

******************************************

ご意見ありがとうございます。 業務分野でも若干仕事をして来ましたので、ご主旨は良く理解出来ます。

時間を販売するに等しい生放送分野では、何よりも一発・そのキーを押せば必ず動作する・・その信頼性こそが命だと理解しております。 (秒単位で売上を大きく差配)

この信頼性を作り込む場合、業務機器設計分野は民生機器とは、まったく異なる次元でアプローチしないと、高度な信頼性は得られません。 当然それを運用するお立場での、機器整備も民生機器とはまったく違う次元のアプローチが求められます。 故にケーブルでの次元では、機器間のインターフェースを取る部分での、事故発生を未然に防ぐ必要がありましょう。

特にライブ演奏を陰で支える技術スタッフの、辛労は察して余りあります。

出演するミュージシャンとは異なる次元で、心臓が口から飛び出るが如き、緊張状態を強いられる事を何度も味わいました。 「本番のここ一発で音が出ない・・リハーサルでは問題なく動作していたのに!・・」そのような場面では、さすがにオロオロさせられます。

自分の知らない間に、勝手に他人が機器の設定を変更していた・・なんてトラブルが有りました。

ほんと!下品ですが、●●をチビル思いが致します。

爺の体験では、心臓に強度の負荷がかかる職業ですね・・お察し致します。

小信号伝送では600Ωの平行ケーブルを使うのが定番ですが、その解説も採り上げます。

解説不備の部分は、プロの眼でご指導をお願い致します。

******************************************

ご意見

1)大変に勉強と参考になりました。御礼の申し挙げようがありません。

2)素人ながら、長年の60年間にああかこうかと思っていた事が頭の中でかなり整理できました。

3)理論的な講義は全く正しく。有意義でした。(一応は物理、電気を収めた技術者でもあります)

4)今回の講義関連ですが、あらゆる面で、短い方が良かったです。次のステップではスピーカーの直 隣に(個々のSPの20CM以内に)アンプを置く(スピーカーの数<約1ダース>つもりです。

数メートルから50CMにしただけで低音だけでなく高音、中音の音色(ダンピング)が換わります

ので、変わらないと言い張る人は本人のせいではなく、耳が鈍いからだと断言して憚りません、

御気のどくな事ですが論外の事です。

5)アンプに関しては、アウトプット・トランスを使った物は綺麗な音が出ますが、ダンピングの良いライ ビーな音はDアンプに遠く及びません。

6)社会精神論は全くその通りです。むしろ、世の中に満ち満ちている、悲しい事であります・・・特に極 一部を除いて、官学出の人にあらゆる職業で手柄(本当は部下や同僚の)を独占する資格と権利 があると憚らず実行する人が多いです。

******************************************

ご投稿ありがとうございます。

爺もこのようなプロの方に評価して頂きますと、勇気百倍です。(笑)

特にD級AMPの真の実力を、十分過ぎる程に分かった上で、システムを構築されておりますね。

プロ・アマ問わず、ケーブル長は必要にして十分な距離で運用される事が、システム上の基本だと観じます。 今後共ご指導・ご意見を下さい。

******************************************

ご質問5

前回(第7回)では、「ご質問の中に信号処理bit 数が上がればデジタルボリュームが成立する・・云々とありましたが、、、」と、以前わたくし(だけではない?)が質問したことに、コメント頂き大変感激しました!

他の方から「24bit処理ではビット落ちは、問題ないのでは、、、」とう質問があったようですね。

私も、質問時そのように考えておりまして、その根拠は「データ長をDレンジに換算すると、1bit=約6dBなので、24bit(実効23bit)のDレンジは138dBもあり、デジタル的に38dB絞ったとしても100dB残るので、実用上は問題ないのでは?」というようなものでした。

今回(第8回)に、それに対するご回答「デジタルボリュームの欠点は、音量を絞った時にS/NのN

(ノイズフロアー)が下がらないこと」を頂き、アナログ式ボリュームとの対比も合わせ、「そういう意味だったのかぁ、、、」と腑に落ちた次第です。

長々と書いてきましたが、今回お聞きしたいことは、「上記のノイズとは、もともとデジタル信号に含まれるノイズと、DAC由来のノイズのどちらでしょうか?」とうことです。

(と申しますのも、アナログボリュームで減衰するノイズとは、プリアンプの上流に起因するノイズと思いますので。)

私は今のところ、マスターボリューム調整をDACの後段に入れたデジタルボリュームIC(MUSES72320)、チャンネル間の音量調整を自作チャンネルデバイダ(半導体式)に組込んだ8chデジタルボリュームIC(シーラス・ロジックCS3318)でおこなっております。

(これらデジタルボリュームICでもMUSES72320などは、内部がラダー型のアナログボリュームになっているので、議論のビットパーフェクトでなくなるデジタルボリュームとはちょっと違うと思っています。)

上記システムを3WAYマルチアンプ(半導体自作)で駆動し、DACの前段にデジタル式イコライザー(DEQ2496)をいれて部屋特性などの補正しているのですが、自作チャンネルデバイダでは、クロスオーバーの調整やスロープを気軽に変更できないこともあり、イコライジングとチャンネルデバイダを一括してデジタルでやりたいと思っています。

最近、ネットで見つけた面白い基板(www.minidsp.com:miniSHARC)を使えば、目論見を達成できることがわかり、作成途中です。

この場合、DACをマルチ化することになり、その後にマルチチャンネル型のデジタルボリュームICを入れても良いのですが、できればシンプルに(デジタルイコライジング+クロスオーバー)基板でデジタル的に音量調節したいと思っていました。

やはりDACの下流でボリューム調整したほうが音質上はいいのでしょうか?

******************************************

そもそもデジタルボリュームが何故成立しないか?

これは、記録系システムの場合、A/Dコンバータ―から送られて来る信号源のS/Nが、24Bit処理と謳っていても、その実力は せいぜい良くて20Bit止まりである事です。(通常は18Bit程度)

同様にD/Aコンバータ―系のBit数も、実力は20Bit程度が性能限界です。

更にAudio機器間のデジタル伝送をすれば、S/Nは必ず劣化します。

ですから、真にDataのS/Nが24Bitあれば・・の前提なら、お説の通りの如くとなります。

デジタルボリュームに入力される上流のS/Nが既に要求するダイナミックレンジを満足しない。

加えて、デジタルボリュームを絞ってもノイズフロアーが下がらず、返って当該エリアでS/N劣化が

発生するのみ・・と言う結果となります。

デジタルEQとチャンネルデバイダ―を完全デジタル化したい・・

このデジタル化システムで申せば、必ずD/Aコンバーターに入力される前段階で、DSPによって処理するのが、ごく一般的です。

このDSPで演算処理する場合、システム上では演算によるオーバーフローを防止する目的で、DSPに入力する前段階で最低でも3dB~4dB程度は、固定値でレベルをデジタル的に下げる設計とします。 故にデジタル処理では、この分S/Nが不利に作用します。(アナログ処理も基本的に同じ)

結論は、DACの上流で全ての信号処理を行い、DAC以降は何も信号を触れない設計が一般的です。

当然マスターボリューム以降の信号処理段で、デジタルEQ・チャンネルデバイダ―を挿入する構成が ごく素直なシステム構成であろうと考えます。

ともかくフルデジタル処理に於けるダイナミックレンジの確保は、思っている以上に困難な設計となり高度な設計テクニックが要求されます。(特に実装設計が・・) 且つその音質を確保するのは、甚だ困難!!・・と言うのが爺の体験です。

特にシステムの回路を実装する段階に於いては、各種クロック間のビートエネルギーの発生を如何に抑え込むかが、システムの成否を担います。 この設計がシステムS/Nを大きく差配します。

ともかく、一度システム構築されて、良い点・悪い点を熟知される事が、技術力を高める事に通じます。

常に限界に挑まないと、自分の技術力は向上しません。 チャレンジしてみて下さい。

成功を祈ります。

水晶振動子は、発生するクロックエネルギーが1種類だと勘違いしている人が実に多い・・

実際は機械振動であり、6種類程度の雑振動エネルギーを内在しております。

つまりクロック周波数にプラスして、その近傍周波数に雑振動成分を必ず伴っている・・と言う事です。

マスタークロック+雑振動エネルギー間との間に生じるビートエネルギーが、システムS/Nを大きく左右します。 この辺りはノウハウ領域であり、詳細記述は不可ですが、一般情報としてシステムを組まれる場合、ご参考にして下さい。・・つまり高度な回路処理と実装技術を必要とします。

******************************************

ご質問6

AD/DAの不正確さについて、昔から疑問に思っています。たとえば4Hzのアナログ信号を10Hzでサンプリングすれば、4回の山谷を記録できますが、4回を均等に配分できません。

それで当初の仕様よりサンプリング周波数を上げた規格もあると拝読し、聴感も改善されるとのご意見でした。「3sizenkaibunpu-スーパーCDフォーマット(DSD)」

さらに、包絡線を再現するのに、プログラム本体をより高い周波数で動作させる場合もあるのでしょうか?

本連載にふさわしくない質問ですが、守秘に反しない情報をお持ちなら、ご教示願えないでしょうか?

小生は画質改善を開発していましたが、単に演算精度を上げるくらいでは画質は向上せず、近隣の色まで考慮して補正していました(処理は遅くなる)。

同様に、音波も波形の過去・未来まで考慮すれば、周波数のユラギや左右チャネルの位相差を緩和できるかと期待しますが、いかがなものでしょう?

******************************************

このご質問もかなり専門的な内容です。 音響信号も同じく限られた伝送帯域を、高精度にData処理 する場合、オーバーサンプリング処理を行います。

音響業界では、CDのサンプリング周波数44.1kHzの256倍程度でA/D ⇒ D/Aの処理が、半導体の処理限界です。その故は、アナログ信号をサンプル&ホールドするアナログ処理回路のSW動作限界に起因します。

画像情報は、大量のDataをメモリー空間に貯めておき、隣接する掃引画像情報を勘案しながら、最適画質になるように、Data処理するのが一般的ですが、音響信号は時間軸上で、隣接する情報の概念がありません。 しかし情報量をサンプリングする周波数空間方向で操作する等は、ごく一般的です。

例えば、32kHzでサンプリングされた音響信号情報を、44.1kHz又は48kHzでサンプリング処理に変換する、又は逆に48kHzを32kHz系の信号に変換処理を行います。

これを、アップ又はダウン・サンプリング、又はアップ・ダウン コンバージョン処理と申します。

この処理も、入力サンプリング周波数に同期して処理する手法と、非同期で処理する手法が存在します。

近年はこの変換手法に、非同期処理が採用され、入力側と切り離しが出来ますので、Data通信時の ジッター排除を行う事が主流となりました。

特にDataをアップコンバート処理する場合、時間軸上ではDataのインターポレーション処理を行いますが、このData量はデジタルフィルターを使って、入力Dataから生成します。

この新たに挿入するData生成演算手法に、かなりノウハウが詰まっております。

当然、新なサンプリング周波数軸上に、この生成したDataを乗せる訳ですが、当然時間軸精度がその性能を背負う訳です。 この時間軸は、入力Dataと非同期の水晶精度で、扱うのが一般的となりました。 この非同期と申しましても、緩やかに入力側と結合処理しておりますが、この手法も各種考え方があり、各社ノウハウ領域です。

ともかく、音響Dataを操作する事は、即音質劣化に繋がるとの思想の元、システムを構築する事が

ピュア-Audioの分野では一般的です。

その一方で、例えば車載用Audioシステムでは、DSP演算とメモリーを使って、3次元の音響空間上で、位相と伝送時間を操作する事が一般的です。 例えば車室空間の如く、SPのニアフィールド空間を効果的に補正処理する事で、最適音響空間が得られる様に修正する事がごく一般的です。

(1980年代後半から、この手法の導入が始まりました。)但しメモリーの隣接Data処理と言う概念は、記録再生系で、誤り訂正をする場合以外には使われません。(CD盤からのData読み取り処理など)

当初音響DataのBit数が、実行量で15Bit程度しか得られず、加えてDSPの演算語長が短く、32Bitでしか無く、その音響性能は一般顧客を満足させるには、不十分な状況でした。

そのような時代を経て、信号Bit数も20Bitが得られ、且つDSPの演算語長が64Bit化へと進歩した現在では、車室空間でも満足が行く、音場の空間制御が出来る様になりました。

同じ処理は、ホームシアターでは既にかなり古くから、デジタル処理が成されております。

しかしピュア-Audioを目指す人々から見れば、これは邪道である・・と見做され、2ch再生だけで

十分であるとする考え方が、主流を成す次第です。 ともかく、アナログにしてもデジタルにしても、信号を各種操作する事は、信号品質の劣化に直結すると考えるのが正解のようです。

当然Dataの誤り訂正率でも音質は変化します。 高級品程この訂正率を低く抑える設計が成されます。

話は変わりますが、HDMIによる画像Dataに付随した音声Dataは、基本的にはパケット通信が使われます。 つまり画像の帰線時間内に音響信号を、多チャンネル分を多重伝送します。

当然画像信号に音声Dataが同期して重畳されており、ジッターが最大の問題です。

これを避ける目的で、大量のメモリーを使って画像系から電気的にAudio信号を分離独立させ、ジッターと画像信号によるAudio系への、信号の汚れを排除する専用半導体が開発され、音響品位向上に資しております。 映像の画質処理に時間がかかる分を、メモリー空間上で音声と画像を時間軸上で同期を取る操作も行っております。 故に、デジタルTVでは時間情報が、絶対時間に対して正しいとは限らないと言う現象が起きております。

ご承知の如く、あらゆる信号の各種補正は、位相歪に直結します。 特にAudioはこれを嫌う訳です。人間の歪成分検出能力は、画像系に対し音響系は圧倒的に高いのが特徴であると、お考え下さい。最近、この音響空間の補正手法に関し、スピーカー次元だけでトライしようと試みている例があります。下記URLをご参照下さい。 癒し空間の演出を狙った商品の様です。

三次元仮想音響システム (株)ダイマジック

https://www.youtube.com/watch?v=Q0vbKknWA7k ・・動画で紹介

更に精緻な、音波の波面制御を採用した、超高級ピュア-Audioシステムの例を、下記に示します。

(今年1月にアメリカのCESで発表)

http://diasoul.co.jp/jp/

有名なAV評論家・麻倉氏の試聴記は、下記を参照下さい。

http://www.stereosound.co.jp/review/article/2015/01/17/35123.html

価格に見合う性能を有しているものと拝察します。中東の石油成金が喜びそうな? システムですね。

******************************************

17-3-3) 小信号増幅の基礎

(1)初段増幅器入門

あらゆるアナログ信号を増幅する場合、俗に言われる増幅回路のフロントエンドの設計が、特に重要となります。 Audio回路ではその回路は、マイクロフォン増幅器の初段増幅回路に相当します。

既に前回記述しました通り、設計上の留意点サマリーを解説しましたが、今回は回路設計の基礎を解説します。

1-1.電流増幅とは?

半導体回路で言う電流増幅の概念について。簡単に見ておきましょう。

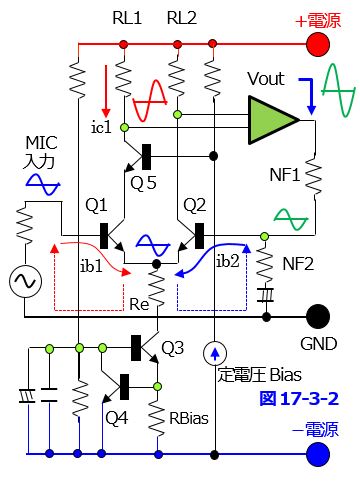

増幅用フロントエンドの構成と、その動作原理を考えます。 その概念図を図17-3-2に示します。

この回路は俗に言われる、差動増幅回路のフロントエンド部分の例を描いたものです。

マイクロフォンで発電された電流エネルギーib1は

フロントエンド増幅用トランジスターQ1のベース

電流として左図の様に流れます。

するとQ1のコレクター電流がic1として+電源からマイナス電源の方向に流れます。

するとトランジスターQ1の負荷抵抗RL1の両端にはMIC出力の電圧位相と反対の逆位相電圧が

負荷抵抗RL1の両端に発生します。

この電圧値は、コレクター電流ic1の分量に比例しします。(ib2側は無視して説明)

Q1のコレクター電流は、下式で表す事が可能です

ic1=ib1×(Q1のhfe)

このhfeの事を、電流増幅量を表すh定数と呼びます

このQ1のコレクター電流は、フロントエンド増幅回路の中で、一番重要な役割を負います。

この電流の絶対値を差配するのは、RL1の値がその大半を差配します。

抵抗ReはトランジスターQ1とQ2の共通エミッター抵抗で、互いの電圧増幅度を決定します。

RBiasは、初段コレクター電流を安定化させる作用をQ3と併せて行います。

以上より、初段トランジスターQ1のh定数が大きい程、コレクター抵抗RL1の両端には大きい電圧が

取り出せる事を意味します。 ディスクリートトランジスターでは、hfeの値は200程度の値を有します

が、高集積度LSIになる程このhfeの値は、大幅に低下します。

その低下分を回路設計テクニックでカバーし、実用製品にまとめているのが現状です。

故にLSI内部と同じ回路構成を、ディスクリートで組めばかなり性能は改善可能ですが、逆に回路規模

が大幅に膨らみ、高周波特性も実装を考えれば低下すると言う副作用を伴います。

1-2.初段の電圧増幅度

初段増幅回路のエミッター側には、マイクロフォンから注入された電流と、コレクター側からの電流が併せて同時に流れ込みます。

この場合、マイクロフォン側のエネルギーによるエミッター側電圧は、Re×(ib1)の電圧が発生します。一方コレクター電流によるエミッター電圧は、Re×(ic1)となります。

即ち、Reの存在で発生した電圧は、トランジスターQ1のコレクター・エミッター間の信号電圧の振幅量として見た場合、エミッター側電圧が上昇しますので、コレクター側に得られる交流電圧は、減殺される方向に作用し、即ちこれは負帰還として回路的に動作します。

このようなエミッター抵抗の存在によって、自動的に負帰還がかかる回路を、セルフNF回路と呼びます。

当然Reの値が大きい程セルフNF量は増大する理屈となります。

では初段トランジスターQ1で増幅される電圧増幅度は?(単純なエミッター接地AMPとして説明)Q1の電流増幅度が一定と仮定すれば、コレクター側に取り出せる電圧は、大雑把にはコレクター抵抗RL1とReの比で決まると考えればOKです。

例えば、Q1のコレクター抵抗が47kΩで、Reの値が47Ωであれば、電圧増幅を示すdB値は、概ね20Log47k/47=60dB と求まります。 (差動増幅は1-5項を参照)

この増幅度は、概ね1kHz付近の値であると考えて下さい。

ハイエンド帯域の周波数になった場合、Q1のコレクター電流の値が大幅に低下し、RL1の抵抗両端に電圧を供給出来なくなり、所謂増幅系の裸Gainが大きく低下します。

この特性は、全てQ1のh定数の高周波特性に依存します。

1-3.高周波帯の増幅度

では何故高周波帯になれば、このh定数が低下するのか?・・と言う問題になります。

最大の理由は、コレクターとベースの間には接合部容量が存在します。 この容量値は一定ですが周波数が高くなる程インピーダンスは低下しますので、コレクター側に生じた負荷電圧が、入力側に漏れて戻って来ます。

つまり、これも高い周波数帯のエネルギーがあたかも、半導体素子内部で負帰還がかかったのと等価になる訳です。 当然半導体としてはこの接合部容量が小さい事が優れた増幅特性を示す必須要件となります。

以上の様子を図17-3-3に示します。

増幅してRL1の両端にせっかく電圧として取り出しても、この接合部容量が 存在する故に、ベース側にエネルギーが戻されてしまい、その戻される程度が 周波数が高くなればなる程、戻される分量が増加し、増幅回路全体としては俗に言われる裸Gain(ユニティーゲイン)が低下する事になります。

この他ベース端子とエミッター端子の間にも接合部容量が存在し、高周波になる程この影響が無視出来なくなり、電流増幅度が低下する方向に働く。

更に都合が悪い事があります。

コレクター電流が増加して、RL1の両端で発生する電圧が大きくなった場合、コレクター側の振幅が

大きい時は、接合部容量が同じでも大きいエネルギーがベース入力側に戻される事になります。

つまり、大振幅になればなる程、高周波帯に於ける裸Gainが低下すると言う現象が発生します。

しかも信号の電圧量に応じて帰還量が変化します。

信号周波数が一定として、その振幅量だけで増幅度が変わる事は、増幅系としてみれば、この現象は直ちに歪に直結する訳です。 このような現象は、あたかも鏡の中に映ったかの如く、振幅に比例して帰還量が変化しますので、コレクター・ベース間容量は、ミラー容量と呼ばれております。

この現象を改善する事が、高性能化への第一歩となります。

1kHz帯では十分な増幅度が得られたとしても、100kHz帯までフラットに伸ばす半導体は、入手が困難で、NFがかかった状態で、遮断周波数を600kHz程度(-3dB増幅度が低下)まで伸ばす設計は、

ディスクリート回路で設計すれば、実装技術を含め大変困難な仕儀となります。

微細化の加工を行うIC化は、高周波特性が圧倒的に有利になります。

1-4.カスコード接続回路

このミラー容量の影響を何とか防ぐ手段は無いか・・と考えられたのが、カスコード接続回路です。

図17-3-2に示した如く、トランジスター Q5を初段増幅回路のコレクター側に挿入する手法です。

コレクター側の振幅は、抵抗器RL1の両端に発生しますので、Q5を挿入する事でRL1による電圧変化 の悪影響をQ1は受けない事になります。

(Q5のコレクター側からQ1のコレクター側を見たインピーダンスが高いと等価)

Q5のベース側は単純に、RL1の振幅基準電圧となるように、直流Bias電圧を与えでおけば良い構成となります。 このカスコード接続は、既に真空管回路の時代から存在する、とても古い設計手法ですが現代のアナログ回路の高性能化に取っては、無くてはならない重要な回路方式です。

OP-AMPを構成するICで、多用されております。

但し電圧利用率が低下しますが、その影響分を見ても他の物理特性改善に、寄与する分が大きい訳です。真空管回路の、詳しいカスコード接続回路の設計例を下記URLに示します。 http://ayumi.cava.jp/audio/pctube/node14.html 演算原理はまったく同じです。

1-5. NF動作・差動増幅

図17-3-2の差動増幅器の片方を、NF端子として使った接続例を示してありますが、この場合の動作を説明します。

トランジスター Q2のベース側には、マイクロフォン信号と同相で、振幅の異なるエネルギーを増幅器の出力段から、電圧を分圧して注入してあります。 この同相エネルギーは、Q1とQ2が供用しているエミッター抵抗に電流ib2として流れます。(差動増幅器として動作)

すると、Reの両端で発生する電圧が上昇する事となります。 即ちこれはQ1のコレクター側で発生する電圧エネルギーを減殺する方向に作用します。(Q1のコレクター・エミッタ―間電の交流圧が小さくなるのと等価)これがネガティブフィードバックとして動作する基本原理です。

初段増幅器を経由して、次段の増幅器で生じた歪・ノイズ分は、全てこの初段トランジスターにフィードバックされる事によって、抑圧される故に各種物理特性が改善される理屈です。

故に、初段増幅用トランジスターの電流増幅率が高い程(裸Gainが高い)回路的には有利に作用します。

既にボーデ線図の項で、解説致しました通り、ここではQ2のベース側に注入する電圧位相が、Q1側の位相に比べて、どの程度高い周波数で回転しているか?

この点が非常に重要な設計指標となります。(既に演算手法含め解説済)

既にOP-AMPの回路Gain演算手法で説明しました如く、NF1とNF2の抵抗比で増幅系全体の増幅度を求める事が出来ます。 図17-3-2は、差動増幅器として記述してあります。

この場合の増幅器出力の演算式は、MIC側からの信号をV1、NF側からの信号をV2とすれば、

Vout = (V1-V2)+(VCM /CMRR) で表す事が出来ます。

VCM 分とは、同相モード電圧分の事で、CMRRとはCommon mode Rejection ratio の事です。 これは同相除去比と訳されます。

次回の差動伝送の項で解説しますが、給電ライン上にリップル電圧が混入していた場合、シングル伝送モードではこの影響を除去出来ませんが、差動増幅器の場合+側からこの分の邪魔な電圧(同相電圧分)を注入すれば、除去出来ます。

同相電圧とは、信号・GND系に混入して来る邪魔なノイズ電圧成分と理解して下さい。

その除去する能力を示したのがCMRRの値で、これはトランジスターQ1とQ2の電気的な対象性によります。 つまり完璧に等しい場合は、V1とV2に含まれる同相モード電圧は打消し合って、出力側には出ませんが、回路をシンメトリーに設計しても、完璧に等しい設計は不可能です。

よって、対称性の崩れが存在し、その程度を表現したのがCMRRの値となります。

この値は大きい程優れておりますが、汎用OP-AMPなら通常90~120程度の値を持ちます。

特に優れたジャンルのOP-AMPは、140程度の品物が販売されております。(軍需用途等)

図17-3-2は左右非対称ですが、カスコード接続を含め左右シンメトリーに設計するのが一般的です。ディスクリート回路設計では、Q1とQ2のエミッタ―間にボリュームを挿入し、DCバランスを取るのはこの対象性を改善する事が目的です。

しかし高い周波数エリアで、高いCMRRの値を確保する事は、甚だ困難となります。 ここに挙げた値は1kHz付近の値であり、100kHz帯になれば良くても、-20程度以上は簡単に低下します。

理由は、半導体のhfeが低下するからです。 又図中のReの値が大きい程CMRRとしては有利な方向に作用しますが、回路の電圧利用率が低下しますので、ここは回路設計屋の腕の見せ所です。

通常LSI化した増幅器であれば、10kHzでCMRR=85以上あれば優秀な部類と考えて良いでしょう。

又駆動電圧の限界付近では、CMRRの値は急激に低下します。(例:±15V駆動なら±12V以上の領域)

以上説明しました通り、初段増幅器の差動AMPに使うQ1とQ2の半導体は、電気的特性の対象性と

通過信号帯域に於けるハイエンド領域でのhfeを、特に高く設計する事が成功への秘訣となります。

加えて、以下に解説します半導体ノイズの性能が、優れた素子が必要となり、通常は器機の用途に応じて専用に開発される事が一般的でした。(爺の現役時代は)・・今は??

多段増幅器の場合は、このフロントエンドの半導体が、あらゆる物理量を大きく左右する事が、この説明で理解出来たものと思います。 その半導体回路を設計する上で、特に重要なノイズ発生への対処手法を次に解説します。

(2) 初段増幅回路とノイズの関係

2-1.増幅回路の初段S/Nを差配する設計要素

設計要件を箇条書きすれば・・

① 信号源抵抗値

② 初段増幅用半導体のコレクター電流値

③ 増幅系の増幅度と伝送インピーダンス

④ 増幅用素子の雑音性能(ショットノイズ・ホワイトノイズ・1/fノイズ)

⑤ ①と②を同時に勘案した、ノイズフィギュア値

⑥ 電源のS/N

⑦ 実装状態(外界からの不要エネルギーを遮断する性能・静電界・磁界)

⑧ 各種振動エネルギーからの防護性能

⑨ その他

これらの設計要素が複雑に絡み合い、総合性能として機器性能が定まる訳です。

特に、設計要素として⑤項のノイズフィギュアの設計検討が、最も重要となります。

それを根本から影響を与える、増幅素子自身の④項の性能が、システムの良否を分けます。

特に、初段増幅用半導体のS/N性能を差配する、半導体自身のノイズフィギュア特性が最重要項目となります。

2-2. ノイズフィギュア(NF)

ここではノイズフィギュアの定義について解説します。

質問

ここに25dBの増幅度を有する小信号AMPが有ったと仮定します。 ではこのAMPを通すとノイズは

一体どのような振る舞いをするか?

信号は25dB増幅される事は理解出来るが、ノイズレベルはどうなる? ノイズも同じく増幅されて

+25dB分Upされる?

答え

ノイズは+25dB分Upにならない・・

では、このノイズフィギュア(NF)の定義について解説します。

ノイズとは、半導体の④項の全てのノイズを包含していると考えて下さい。

(NF)の定義 = 入力S/Nと、増幅回路の出力S/Nの比で表す。

具体的な数値を当てはめて考えてみます。

マイクロフォン入力の信号電圧(SVin)が2mV(約―54dB)

この時のノイズ電圧(NVin)が0.01μV(-140dB)であったと仮定します。

すると、入力側のS/Nは、-140-(-54)=86dB

25dB(17.78倍)増幅した後の信号電圧は、35.56mV(-28.98dB)

この時の出力側ノイズ電圧が、2.25μV(-112.95dB)であったと仮定します。

出力側のS/Nは、 -112.95 - (-28.98) = 約84dB

この時の(NF)値は?

(NF)=86 - 84 =2・・・即ち25dB増幅する事で2dB劣化した事になります。

結論は、増幅後のノイズは、(NF)値だけ劣化するです。

ここから先がいよいよアナログ回路設計の、肝心要の話となります。

2-3.ノイズフロア低減設計の物理的根拠

アナログ増幅器を設計する場合、一体何を根拠に低雑音AMPを設計するのか?

この疑問に答える必要があります。

当然2-1項の①から⑨を念頭にした設計を行うのですが、此れだけの情報では一体何を、どの様に設計すれば良いか? 皆目見当も付きません。

ノイズ制御の本質

ノイズの発生要因は、主に半導体自身から発生する事が最大要因ですので、設計に当たっては半導体のパラメーターとノイズ量との関係を正しく理解する必要があります。

まず何よりも、2-1の④項の基本性能が、他の一般的な半導体よりも優れている必要があります。S/N改善の要諦は・・

① アナログ増幅回路を駆動する電源電圧を上げる。

② ノイズの基礎的な絶対量を低減した半導体が必須、特に増幅回路の初段用半導体が重要。③ 上記(NF)値を低減する半導体を開発する。

④ (NF)値低減は、各種の設計パラメーターが関与する。

・初段コレクター電流の分量に対する(NF)値

・初段コレクター電流の分量に対する(NF)値

・信号源インピーダンスの値に見合う、最適コレクタ-電流値の設定

・(NF)値の周波数依存性を低減する

・半導体上に流れる電流分布の均一性を重視

・可能な限り高いhfeの値を持つ初段増幅用半導体を選ぶ

与えられたパラメーターでは、システム性能が得られない場合、専用半導体を開発する事になります。

今のご時世で、Audio専用のディスクリート半導体開発は、夢のまた夢ではなかろうか・・と思います。

ここでは、(NF)量を直接差配するアナログ回路設計の要諦について解説します。

システム設計側の立場で、最も重要な物理量は、(NF)量が最小値を与える初段コレクター電流の設定となります。

(NF)量を最小にする信号源インピーダンスとコレクター電流の関係

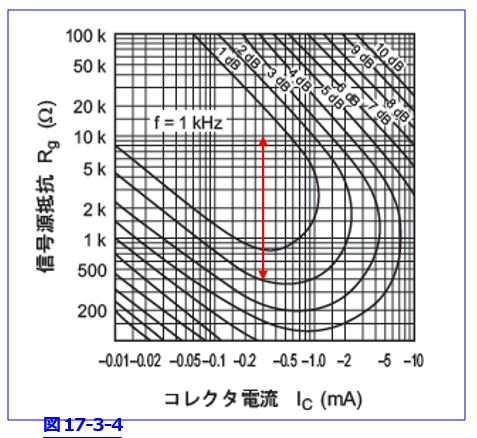

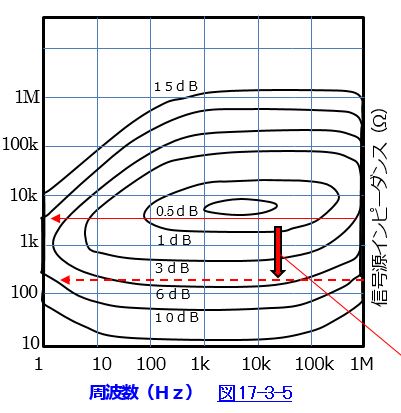

(NF)量・信号源抵抗・コレクター電流の関係について、計測したDataを、図17-3-4に示します。

グラフの説明

これはNFの周波数が1kHzに於ける等NF曲線です。(PnP型半導体)

信号源抵抗とコレクター電流の値を振ってNF量を計測した場合、同じNF量を維持するに必要なコレクター電流と信号源抵抗の関係を計測したものです。

このグラフには(NF)=0.5dBの範囲が示してありませんが、概ね信号源抵抗は、800Ωから20kΩの範囲内なら、最適コレクター電流は300μAで設計すれば良い事を意味します。

マイクロフォンAMPであれば、信号源インピーダンスの周波数特性が分かれば、それに見合う半導体側の最適コレクター電流が決まる訳です。

信号源抵抗は、小さすぎても・大きすぎても(NF)値は良くならない・・半導体側の特性を信号源抵抗側の都合に合わせて作り込む・・これが設計上の正しいアプローチとなります。

物理的限界を改善しようと試みるなら、(NF)値の最適ポイントを求めて、半導体を専用に設計する必要がある。 発電機であるマイクロフォンの信号源抵抗は、既に存在するので、この場合は半導体側の(NF)特性をマイクロフォンの都合に合わせるのが、一般的なアプローチでしょう。

或いは、その両方から総合的に(NF)値改善に取り組む事が求められます。

更にアナログ回路設計では、このままでは不十分であり、(NF)値の周波数特性を追及します。

その特性を図17-3-5に示します。

単純に低雑音のOP-AMPとマイクロフォンを組み合わせるだけでは済まない設計上の問題です。

この図は、コレクター電流を最適値に固定して信号源抵抗を変化させた時の、(NF)値の

周波数特性を計測したものです。

この特性は、信号源抵抗が概ね2~8kΩ周辺で使った時に、(NF)値が最小で且つノイズ の周波数特性も良い事を示します。

図17-3-5に示すが如くの特性ではマイクロフォンAMPには適さない事が理解出来ます。

スタジオで使業務用のマイクロフォンの場合50Ωから200Ω程度が一般的です。

この図では、赤⇒の如くNF値の信号源抵抗を赤破線位置まで引き下げる必要があります。

かなり昔のディスクリート半導体を使った、マイクロフォンAMPではこの初段増幅用半導体に、超低雑音トランジスターが開発され、使われておりました。(今では入手不可能?)

半導体を低雑音化する手法として、コレクター電流の流れる半導体上の、電流密度を下げる手法が使われました。

これを実現する手法の一つに、リングエミッター方式と言う拡散手法が使われました。

(今でもこの手法は、低雑音化には有効の筈。低雑音・高耐圧OP-AMPでは同じ手法が使われている筈)見かけ上は、トランジスターを並列に沢山接続したのと等価にする、半導体構造の設計手法。

パラレルと等価にする事で、電流の密度を低減する考え方です。

2-4)低雑音を評価する指標

専門的になりますが、半導体に流れる電流の熱雑音で、白色雑音(ホワイトノイズ)と呼ばれる設計

アイテムがあります。 基本的には、既に解説しました抵抗の熱雑音と同じ考え方です。

半導体の中では電荷を励起する物理的なポテンシャルエネルギーの壁が存在します。

つまり、この壁を乗り越えないと電流が流れないと言う事になります。

要するに、このエネルギーの壁によって、連続した値で電流が流れず不連続な流れとなる故に、これがNoiseとして現れる訳です。この電流を演算式で表せば・・

I2 =2q×Ia× Δf

q=電子の電荷 1.6×10-19 クーロン

Ia = 平均電流

Δf=電流の周波数帯域

この式を変形して、1Hz当たりに直せばi=5.66×10-10√Ia と表現する事が可能です。

従って、トランジスターの負荷抵抗Rの両端に生じるノイズ電圧を表現する場合は下式となります。

V2 = 4kTRΔf

室温=300K で1kΩの両端に発生する雑音電圧は、電流の通過帯域√1Hz当たりで表現すれば下式です。

√V2 = nV/ √Hz at 1kHz

このnの値の大小でノイズ性能が判断出来ます。OP-AMPのカタログ値にこのnの値の記載があります。 実際は、電流の通過帯域巾に宛てて評価しますので、√Hz とnの値でノイズ量は決まります。

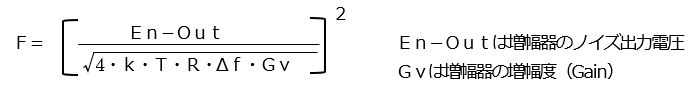

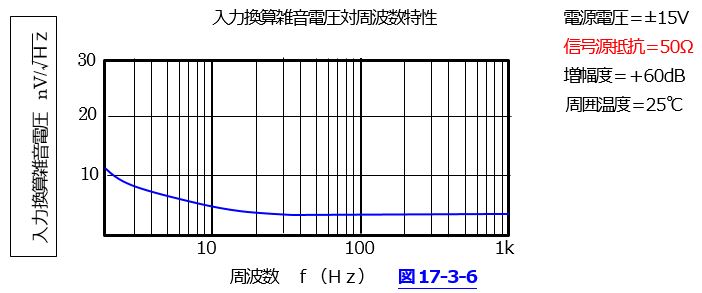

そこで、これを(NF)ノイズフィギュアとして表現する場合を考えます。

電機で発生するノイズと、増幅器で発生するノイズの比で、優劣を評価する訳ですので、(NF)を

ダイレクトに表現する演算式に書き換える事が可能です。

En-Outは増幅器のノイズ出力電圧

Gvは増幅器の増幅度(Gain)

ルートの中味は抵抗の熱雑音式で、これに増幅器のGainであるGVが加わります。

(NF)は電力式で扱いますので、最終的な指標としては、(NF)=10LogFとして表現します。

一方的にノイズだけ追及しても、物理的限界の壁に突き当たり回答がありません。

よって、増幅器の駆動電圧を上げて最大振幅信号電圧を稼ぐ設計が必須となります。

但し、この場合電圧上昇に伴いノイズも合わせて上昇しますので、高電圧駆動時のnの値がキーポイントとなります。 最近ではn=1を切る値の(nV/√Hz) OP-AMPが、各社から発表されております。

更に低雑音だけでなく、信号のスルーレート特性も、音質次元で考える必要があります。

駆動電圧が60V程度かけられる、トランスジューサー系に接続可能なOP-AMPが、海外の半導体

メーカより提供されております。

カタログDataによれば、n=1.1で、スルーレートは27Vμsとあり、優秀な部類の様です。

但しノイズは、まだこのn値では満足が行かないレベルですね。(nは通常単位がナノV)

ともかく、一般市販のOP-AMPを使った回路設計では限界が存在する次第です。

業務用分野でも、初段マイクロフォン増幅器は、性能限界を目指すのであれば、ディスクリート回路で設計されるべきでしょう。 (現在はたぶん半導体入手が不可能?故に高性能OP-AMPで代用)Audio用Op-AMPの入力換算雑音特性の例を、図17-3-6に示します。

周波数が低いエリアで、nV/√Hz が増大しているのは、1/fノイズの影響を受けております。

入力換算雑音対周波数特性

このノイズ特性の値は、入力換算のDataであり、特に低雑音と言う訳ではありません。

但し、このOP-AMPも給電電圧が30Vであり、初段の業務用マイクロフォンAMPには使えません。

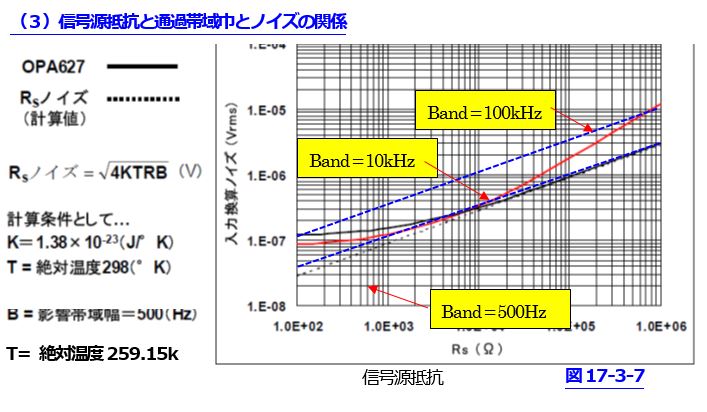

(3)信号源抵抗と通過帯域巾とノイズの関係

この図はTI社のDataに追記したものです。

この図は、信号源抵抗が変化した時、OP-AMPの出力側に発生するノイズ電圧の実効値が変化する様子を示したものです。(赤と黒の実線) 信号の通過帯域巾をDC~500Hzに設定した時のData。

17-3-7の解説

この黒の破線が、信号源抵抗から発生する理論熱雑音電圧を示します。

それに対して、この理論ノイズ電圧から上にあるOP-AMPのノイズエリア内では、この製品は使えない事を表現しております。

即ち、信号源抵抗から発生するノイズ電圧以内に、OP-AMPのノイズ特性が収まっている事が必須条件である事を意味します。

このカーブは信号通過帯域を500Hzに限ったDataですが、信号の通過帯域を更に広げて、10kHzと100kHzで示したカーブが青の破線カーブとなります。

このOP-AMPは通過帯域を500Hzで示しておりますので、直接青のカーブに当て嵌めて読めませんが、通過帯域巾100kHzで考えると、信号源抵抗が100Ωでは常温で0.378μVの値を取ります。

マイクロフォンAMPでは、信号源抵抗が最大200Ω程度なので、大雑把ですが通過帯域を100kHzで

評価して、OP-AMPのノイズ性能は、この図から入力換算ノイズ電圧で、0.05μV(-146dB)以内に

抑える必要があると理解出来ます。 もし初段マイクロフォン増幅回路全体の増幅度が25dBであれば増幅器の出力側には、約0.89μV(-121dB)以下にノイズを抑える必要があると、理解出来ます。

アナログの設計をされた方であれば、この値が如何ほどの重みを持つか??

そして其処に到達する事がどれ程の困難さを伴うか??

直ぐに理解出来ましょう。 更に600Ω平行伝送なら、同様に入力換算で0.09μV以下に、マイクロフォン増幅系出力のノイズ電圧を抑える必要があります。 (Aネットワークを介して評価)

この増幅回路にエネルギーを給電するシステムの困難さが、ただちに理解可能です。

故にバッテリー駆動の給電回路が、高品位な生音の収録現場では使われる所以です。

ここでは、ノイズの理論限界について解説しております。 その視点で眺めて下さい。

4) マイクロフォン増幅回路の初段増幅度

既に解説しましたが、初段半導体内部での増幅度は可能な限り高く設計します。

(RL1・RL2とReの比率)

当然周波数方向で見ても、高い周波数帯でhfeの値が高い半導体を採用する事が必須要件となります。

それだけでは性能的に不足で、加えて超低雑音である必要があります。

同時にこの回路を駆動する給電装置の回路S/Nも、Dレンジ的には130dBを十分クリアーする性能を必要とします。

マイクロフォン感度は、通常振動板歌口から1m離れた処で、1パスカルの音圧を与えた時に、出力端に発生する電圧で性能を評価します。 例えば、SHURE社のSM58型ダイナミック型マイクロフォンでは、-54.5dB(1.88mV) dB 1V/Paとあります。 又AKG社のコンデンサマイクロフォンの例で、C414B-XLS型ではー33dB(23mV)とあります。(最大入力音圧=140dB SPL )

AKG社のC414B-XLS型は、カタログに記述がありませんが、最大音圧が入力された場合のマイクロ

フォン出力は、+12dB程度の電圧(4V rms程度)が発生するものと思われます。 この範囲の入力電圧を、初段増幅系で飽和させる事無く増幅する回路を設計する必要があります。

このような広いDレンジを扱う場合、業務用では-20dBのアッテネータを入力段に装備する事が一般的です。 概ね初段増幅回路でのNF後の増幅度は、20dB程度に選択される事が一般的です。

初段増幅で信号が飽和すると、マスターボリュームを絞っても意味を成さない事になります。

よってマスターボリューム以降で、システム全体で必要とするトータル増幅度を稼ぐ構成に設計します。

しかし、平均音圧は低い事が一般的で、この時特に過大な音圧を受けると増幅器が飽和します。

これを防ぐ目的で、その瞬間だけー20dBの減衰器を挿入する事は不可能ですから、リミッターを使う事になります。

初段増幅器の駆動電圧を、ファントム電源からと仮定すれば、前回記述の如くVm=46Vとすれば、実効値で32.52Vrmsとなり、マイクロフォン出力との落差は28.52Vrmsとなります。

つまり、4Vの信号を入力して28.52V迄は増幅出来る事となり、概ね+29dB程度は増幅可能と分かります。 ・・運用上は、マイクロフォンの傍で+20dB程度増幅した後に、ミキシング卓に600Ωの平行伝送ケーブルで送り、信号がミキシング処理される訳です。

以上はマイクロフォンAMPと断って解説しておりますが、この設計手法はあらゆるトランスジューサーと初段信号増幅器の設計に対して適用できる、アナログ設計の基本事項となります。

多段増幅時のノイズ発生と演算手法、増幅回路への給電手法・信号の平行伝送等は、次回と致します。

本日もお付き合いを賜り、真にありがとうございました。 爺 拝

爺の喫茶室へのアクセス

↓↓↓

http://ziinokissa.jugem.jp/

今回は古典に学ぶの5回目です。 今回は釈迦仏法の歴史的背景(説いた順)釈迦の予言 等です。